如何评价 Meta 新论文 Transformers without Normalization?

Normalization这个事得好好掰扯掰扯。 上古时期,网络经常在初始几个iteration之后,loss还没下降就不动,必须得把每一层的gradient与weight的比值打印出来,针对性地调整每一层的初始 …

大模型 (LLM) 中常用的 Normalization 有什么? - 知乎

LayerNorm 其实目前主流的 Normalization 有个通用的公式 其中, 为均值, 为归一化的分母,比如对 LayerNorm 来说他是标准差,对 WeightNorm 来说是 L2 范数。 和 为可学习的参数,可 …

数据预处理的归一化手段应该如何应用到训练集,测试集和验证集 …

batch normalization存在以下缺点: 1.对batchsize的大小比较敏感,由于每次计算均值和方差是在一个batch上,所以如果batchsize太小,则计算的均值、方差不足以代表整个数据分布;2.BN …

怎么理解running mean和running variance? - 知乎

怎么理解running mean和running variance? Batch Normalization的running mean和running variance是什么? 显示全部 关注者 8 被浏览

CNN为什么要用BN, RNN为何要用layer Norm? - 知乎

Normalization 不管是 Batch Normalization 还是 Layer Normalization, Normalization的目的是为了把输入转化成均值为0方差为1的数据。 换句话说,这里的 Normalization 其实应称为 …

如何理解Batch Normalization中的scale and shift? - 知乎

Batch Normalization如何解决covariance shift的问题? 既然是分布不同导致的问题,那就同一所有层的neurons值的分布 于是,就有了normalization: mean = 0, variance = 1 但是为什么需要 …

深度学习中 Batch Normalization为什么效果好? - 知乎

Normalization是一个统计学中的概念,我们可以叫它 归一化或者规范化,它并不是一个完全定义好的数学操作 (如加减乘除)。 它通过将数据进行偏移和尺度缩放调整,在数据预处理时是非常 …

Batch Normalization在推理过程是如何设置方差和期望的? - 知乎

Batch Normalization在推理过程是如何设置方差和期望的? 批量归一化操作在前向过程中的计算中需要批量的方差和期望,那么这两个值在单个测试样本推理阶段是如何得到的呢? 若是直接 …

为什么batch normalization在训练和测试时使用的均值和方差的计 …

为什么batch normalization在训练和测试时使用的均值和方差的计算方式不同? 谈谈Tensorflow的Batch Normalization 中尾段提到测试时使用的均值和方差计算使用了一个滑动窗口平均(看代 …

Batch normalization和Instance normalization的对比? - 知乎

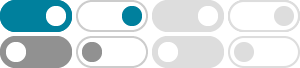

Instance Normalization 上图中,从C方向看过去是指一个个通道,从N看过去是一张张图片。每6个竖着排列的小正方体组成的长方体代表一张图片的一个feature map。蓝色的方块是一起进 …